我院研发出神经网络对抗性样本测试工具

随着人工智能的飞速发展,人们在图像识别、语音识别等领域的识别能力有了显著提升,并将AI算法应用到了无人车、无人机、机器人等多种智能设备。然而研究发现,基于数据驱动的AI算法容易受到数据的影响而出现错误,这在近几年媒体披露的自动驾驶事故中也得到证实。因此,在AI算法落地投产前进行相应的测试评估是目前亟需开展的工作。

针对AI算法测试评估,结合AI算法运行机制,在一些特定的样本场景,可通过对抗攻击的方式有针对性地发现AI算法存在的问题或漏洞,并进行模型的防御增强。基于此,我院人工智能测试评估团队研发出了2款人工智能测试评估产品:AdvNN-B神经网络对抗性样本黑盒测试工具和AdvNN-W神经网络对抗性样本白盒测试工具,致力于推广和完善人工智能测评方法和产品。

1.AdvNN-B 神经网络对抗性样本黑盒测试工具

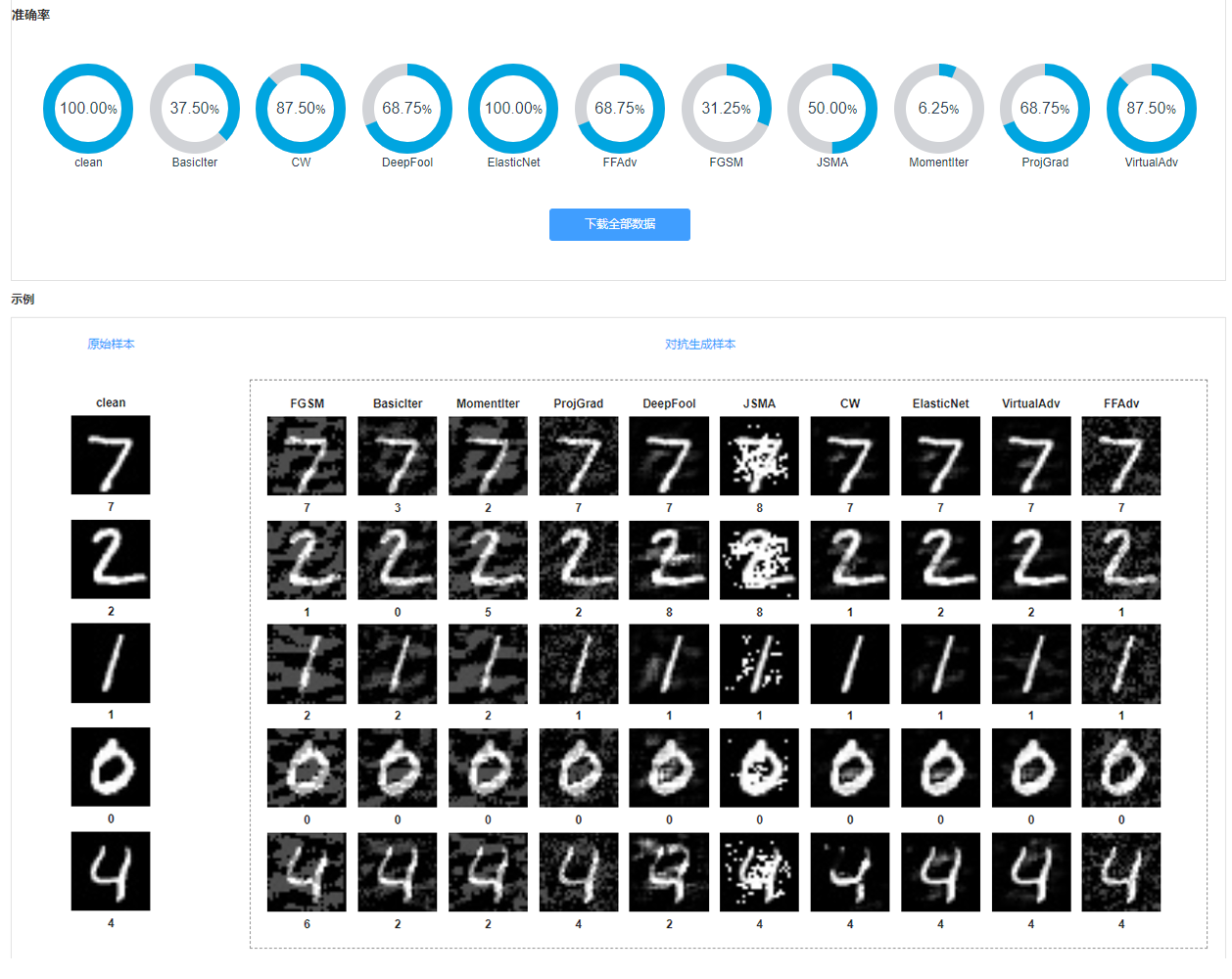

神经网络对抗性样本黑盒测试工具AdvNN-B提供了一个完全可视化的交互界面,支持利用替代的神经网络模型,基于模型输入输出关系,通过对抗样本生成算法间接地生成对抗样本。用户只需要在可视化界面上导入模型和数据,并选择对抗生成算法,即可完成整个对抗样本的生成,避免了从环境部署、参数调整、代码运行到样本生成的繁琐操作。AdvNN-B将对抗样本生成结果以可视化的形式呈现给用户(图1),用户可以直观查看每种算法生成对抗样本的准确率,同时实现对AI算法的有效测试评估。

图1:AdvNN-B运行结果展示

2.AdvNN-W 神经网络对抗性样本白盒测试工具

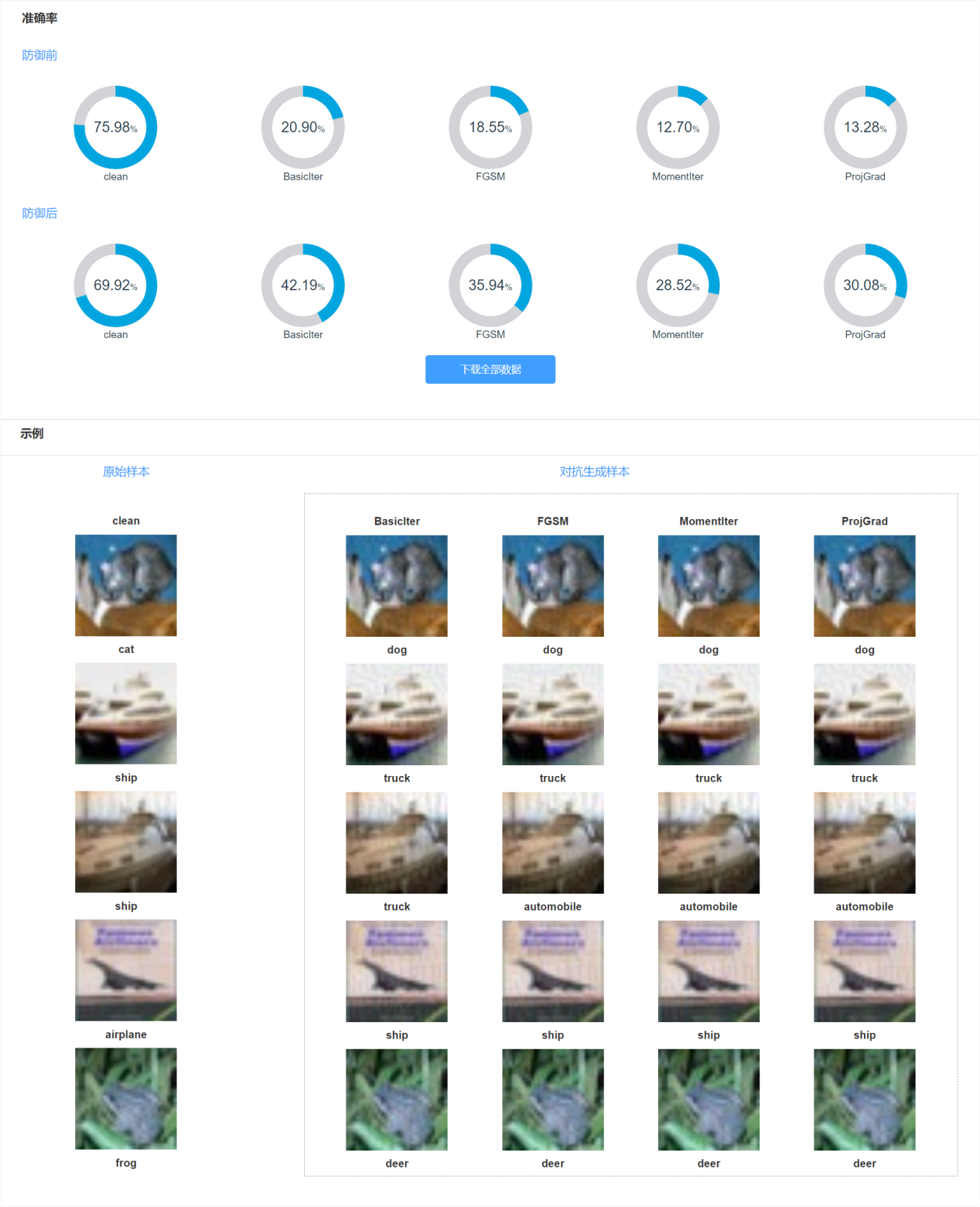

神经网络对抗性样本白盒测试工具AdvNN-W能够基于已知的神经网络模型结构,利用集成化的对抗样本生成算法自动生成对抗样本,整个对抗样本生成操作过程直观可视。此外,AdvNN-W还提供了模型增强功能,能够有效提高神经网络模型面对攻击时的防御能力。通过对抗样本生成和模型增强,AdvNN-W最终将运行结果以可视化的形式呈现给用户(图2)。基于AdvNN-W的结果,不仅能够帮助用户评估每种算法生成对抗样本的效果,同时,通过防御前后结果的对比,还能找到提高模型防御能力的有效手段。

图2:AdvNN-W运行结果展示

(数据集是cifar 10的对抗及增强效果)

我院人工智能测试评估团队是国内最早聚焦于人工智能算法及系统测试、度量和评估的研究团队之一,主要研究方向包括:人工智能算法及系统的可信赖性、安全性及可靠性理论研究;智能无人系统测试理论和测试环境的开发与应用;人工智能算法及系统度量与测试技术的开发与应用。